Datenmodellierung – unverzichtbare Grundlage für präzise Datenanalysen

Self-Service BI-Systeme ermöglichen es Unternehmen, dass ihre Mitarbeitenden eigenständig Datenanalysen durchführen und Berichte erstellen können. Doch trotz der zunehmenden Benutzerfreundlichkeit von Business Intelligence Lösungen bleibt eine solide Datenmodellierung unverzichtbar, da diese das Fundament für konsistente, genaue und leistungsfähige Analysen bildet. Doch die Komplexität der Datenmodellierung, der Aufwand, der damit einhergeht, und der Mangel an qualifizierten Fachkräften stellen viele Unternehmen vor grosse Herausforderungen. Wir erklären, warum Sie dennoch darauf achten sollten, Ihre Datenmodelle optimal zu gestalten, um den vollen Nutzen aus Ihren BI-Analysen zu ziehen.

Was ist Datenmodellierung?

Datenmodellierung ist der Prozess der Erstellung eines strukturierten Datenmodells, das die logischen Beziehungen und Attribute der Daten in einem System definiert. Sie dient dazu, Daten so zu organisieren und zu strukturieren, dass sie effizient gespeichert, abgerufen und analysiert werden können. Daher ist eine gute Datenmodellierung entscheidend, um Daten aus verschiedenen Quellen in ein BI-System zu integrieren und für Analysen und Berichte aufzubereiten.

Arten von Datenmodellen

Der Entwurf von Datenbanken beginnt auf einer hohen Abstraktionsebene und wird dann zunehmend konkreter. Das Datenmodell wird dabei von einem konzeptionellen Modell bis zu einem logischen und dann physischen Modell weiterentwickelt.

- Konzeptionelles Datenmodell: Ein konzeptionelles Datenmodell hat ein hohes Abstraktionsniveau, das die wichtigsten Entitäten und deren Beziehungen beschreibt, ohne sich um technische Details zu kümmern. Es wird verwendet, um die Geschäftsanforderungen zu verstehen und zu dokumentieren.

- Logisches Datenmodell: Ein logisches Datenmodell detailliert das konzeptionelle Modell weiter, indem es spezifische Attribute sowie Primär- und Fremdschlüssel definiert. Es ist immer noch technologieunabhängig, bietet jedoch eine genauere Darstellung der Datenstruktur.

- Physisches Datenmodell: Ein physisches Datenmodell beschreibt dagegen die konkrete Implementierung des logischen Modells in einem spezifischen Datenbankmanagementsystem (DBMS). Es berücksichtigt technische Aspekte wie Datentypen, Indizes, Partitionierung und Performance-Optimierungen.

Der Prozess der Datenmodellierung

Um Daten möglichst optimal zu Modellieren, wird häufig einem iterativen Prozess gefolgt, dessen Arbeitsauflauf meist wie folgt aussieht:

- Entitäten identifizieren: Zunächst werden Daten konkreten Geschäftsobjekten zugeordnet, den sogenannten Entitäten. Eine Entität repräsentiert also ein eindeutig identifizierbares Objekt oder Konzept in einem Datenmodell, das relevante Informationen speichert. Das können beispielsweise Kunden, Produkte oder Verkäufe sein.

- Attribute identifizieren: Jede Entität kann von anderen unterschieden werden, weil sie ein oder mehrere eindeutige Attribute hat. Das sind Eigenschaften und Merkmale, wie z. B. Name, Kundennummer, Adresse oder Datum. Diese Attribute werden den Entitäten zugeordnet.

- Beziehungen definieren: Anschliessend wird über Primär- und Fremdschlüssel festgelegt, wie die einzelnen Entitäten und Attribute miteinander in Beziehung stehen, also z.B. welche Verkäufe von welchen Kunden getätigt wurden. Diese Verknüpfungen können viele verschiedene Formen annehmen, wie z.B. Eins-zu-Eins-, Eins-zu-Viele- oder Viele-zu-Viele-Beziehungen.

Ein Attribut oder eine Kombination von Attributen, die eine Entität eindeutig identifiziert, nennt man Primärschlüssel. Der Wert des Primärschlüssels muss dabei einzigartig sein. So kann beispielsweise eine Kundennummer der Primärschlüssel der Entität „Kunde“ sein. Dagegen ist ein Fremdschlüssel ein Attribut, das eine Beziehung zwischen zwei Entitäten herstellt, indem es auf den Primärschlüssel einer anderen Entität verweist. Beispielsweise könnte ein Fremdschlüssel der Entität „Bestellung“ auf die Kundennummer verweisen, um anzugeben, welcher Kunde die Bestellung aufgegeben hat.

Datenmodellierungstechniken und -methoden

Datenmodellierungstechniken definieren die logische Struktur von Daten und bestimmen, wie sie gespeichert, organisiert und abgerufen werden. Die drei wichtigsten Arten sind das relationale, das dimensionale und das Entity-Relationship-Datenmodell. Weitere, weniger häufig genutzte Modelle sind das hierarchische, objektorientierte, Netzwerk- und Multivalue-Modell.

1. Relationales Datenmodell

Das relationale Datenmodell ist die älteste der drei Datenmodellierungstechniken, ist aber dennoch weit verbreitet. Es speichert Daten in Datensätzen mit festen Formaten und in Tabellen mit Zeilen und Spalten. Dieses Datenmodell verfügt über zwei Elemente:

- Kennzahlen: Numerische Werte wie Mengen und Erträge werden für mathematische Berechnungen verwendet, wie beispielsweise Summen oder Durchschnitt.

- Dimensionen: Dagegen sind Dimensionen Text oder numerische Werte, die Beschreibungen oder Orte enthalten und nicht für Berechnungen verwendet werden.

Diese Elemente werden mit Schlüsseln miteinander verknüpft oder in Beziehung gesetzt.

2. Dimensionales Datenmodell

Dimensionale Modelle sind flexibler und fokussiert auf kontextbezogene Daten. Daher sind sie ideal für Online-Abfragen und Data Warehousing, wie es häufig für BI-Systeme verwendet wird. Hier sind die wichtigsten Elemente Fakten und Dimensionen:

- Fakten: Fakten sind wichtige Datenelemente wie Transaktionsmengen.

- Dimensionen: Die Fakten sind verbunden mit Referenzinformationen wie beispielsweise Produkt-ID oder Transaktionsdatum. Diese Referenzinformationen werden Dimensionen genannt.

In dimensionalen Modellen sind die Faktentabellen eine Primärtabelle. Diese Struktur ermöglicht schnelle Abfragen, da die Daten für eine bestimmte Aktivität zusammen gespeichert werden. Allerdings können fehlende Beziehungsverknüpfungen die Nutzung der Daten erschweren und die Datenstruktur ist an die Geschäftsfunktion gebunden, die die Daten generiert und benutzt. Das kann die Kombination von Daten aus verschiedenen Systemen erschweren.

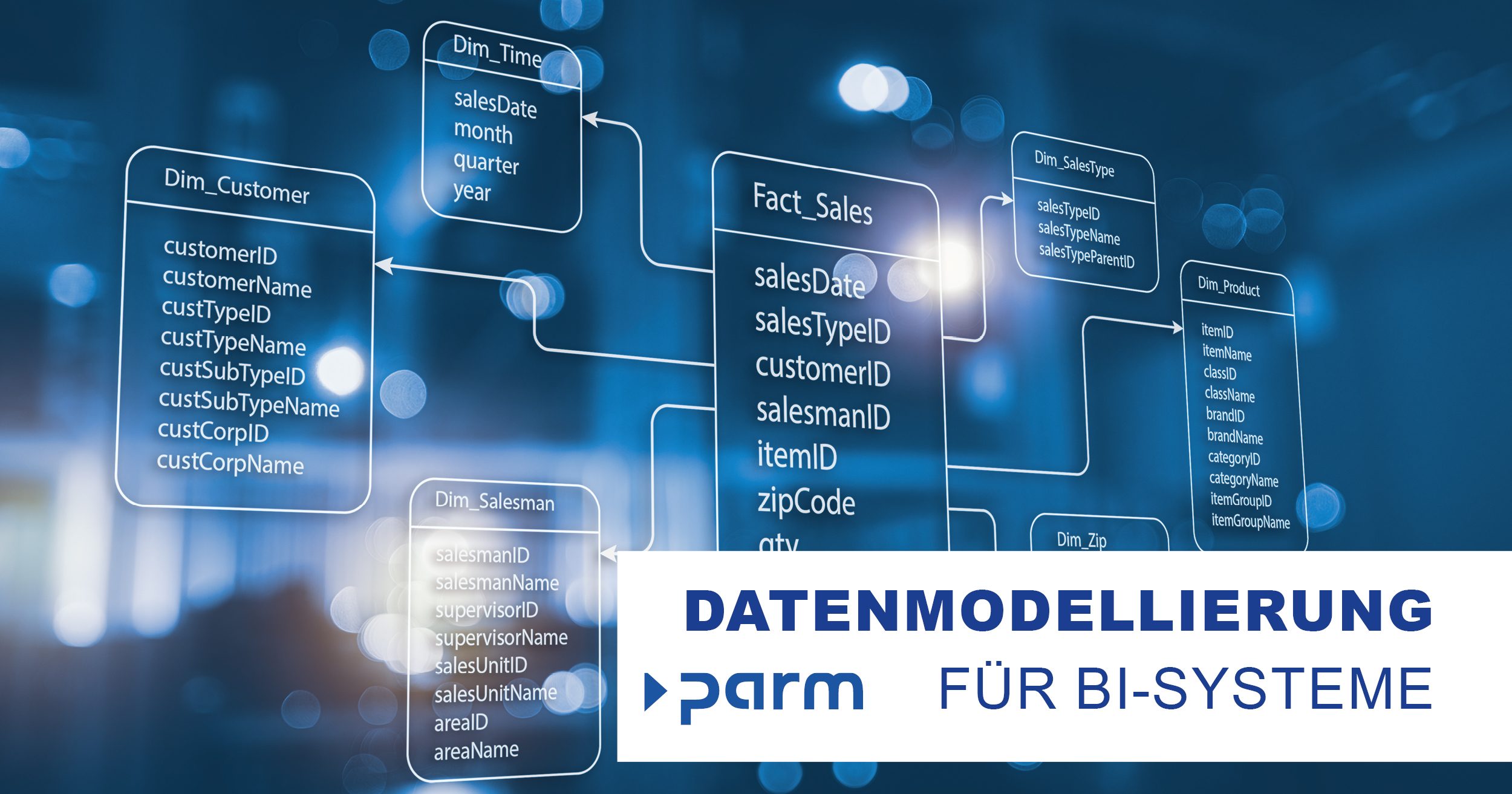

Zwei besonders häufig genutzte dimensionale Modellierungsschemata sind das Sternschema und das Schneeflockenschema. In einem Sternschema ist eine zentrale Faktentabelle direkt mit mehreren Dimensionstabellen verbunden. Diese Struktur ist einfach und effizient für Abfragen, da alle Dimensionen nur eine Verbindung zur Faktentabelle haben. So ist das Schema leicht verständlich und eignet sich gut für einfache Analysen und Berichte. Das Schneeflockenschema ist eine Erweiterung des Sternschemas, bei dem Dimensionen weiter normalisiert werden, d. h. Redundanzen werden minimiert. Dafür werden Dimensionstabellen in mehrere verknüpfte Tabellen unterteilt, was die Struktur komplexer macht. Das kann die Datenintegrität verbessern, aber auch die Abfragekomplexität erhöhen.

3. Entity-Relationship-Modell (ER-Modell)

Das ER-Modell visualisiert Geschäftsdatenstrukturen grafisch. Es verwendet Symbole für Entitäten, Aktivitäten und Funktionen sowie Linien für Beziehungen, Zusammenhänge und Abhängigkeiten. Ein ER-Modell dient als Grundlage für den Aufbau relationaler Datenbanken, wobei jede Zeile eine Entität und die Felder Attribute enthalten. Die einzelnen Tabellen sind wiederum durch Schlüssel verknüpft.

Fazit

Die Datenmodellierung bildet die Grundlage für alle BI-Aktivitäten. Eine gut durchdachte Datenmodellierung ermöglicht es, dass die Daten konsistent, akkurat und leicht zugänglich sind. Sie verbessert die Datenqualität und -integrität und stellt sicher, dass die Daten den Geschäftsanforderungen entsprechen. Die so effizient organisierten Daten können leicht abgerufen und analysiert werden, sodass sie optimal für datenbasierte Geschäftsentscheidungen verwendet werden können. Trotz der Herausforderungen und der Komplexität, die mit der Datenmodellierung einhergehen, ist sie also unverzichtbar, um den vollen Nutzen aus BI-Initiativen zu ziehen.

Uns bei der Parm AG ist allerdings bewusst, dass der Mangel an Fachkräften sowie die hohe Komplexität der Datenmodellierung eine grosse Herausforderung für viele Unternehmen sind. Daher unterstützen wir Sie gerne bei dieser Aufgabe. Von der Erstellung eines Konzeptes bis hin zur Datenmodellierung und anschliessender Reportgestaltung übernimmt unser Expertenteam die Datenmodellierung für Sie, sodass Sie sich auf Ihr Kerngeschäft konzentrieren können, während wir die Grundlage für Ihre BI-Erfolge schaffen. Unsere OLAP-gestützten Lösungen gewährleisten dabei, dass auch schnelle, komplexe Abfragen, unterschiedliche Darstellungsweisen der Daten, sowie Einzel- und Trendanalysen möglich sind.

Weitere Informationen über die Business Intelligence Software myPARM BIact:

Möchten Sie myPARM BIact in einer Demonstration kennenlernen? Dann vereinbaren Sie gleich einen Termin!